La qualité des réponses des IA face à la concentration des sources d'information

La qualité des réponses des IA face à la concentration des sources d’information

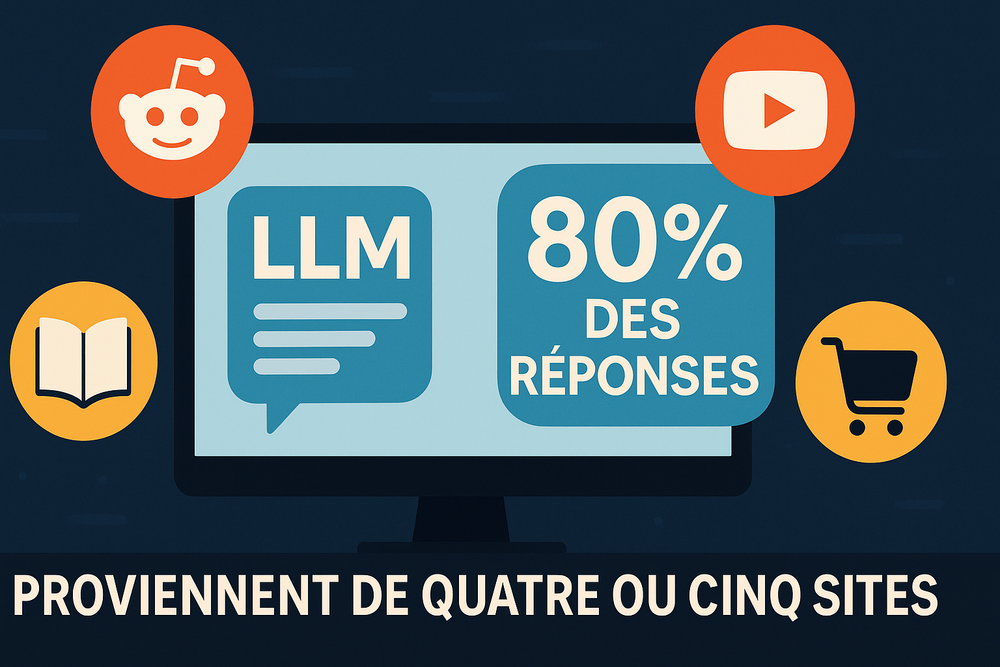

Saviez-vous que la réponse que vous obtenez d’un chatbot d’intelligence artificielle pourrait provenir d’un forum en ligne rempli de discussions entre passionnés ? Les modèles de langage (LLM) comme ChatGPT ou ceux intégrés aux moteurs de recherche impressionnent par l’étendue de leurs connaissances. Pourtant, une analyse récente de milliers de réponses générées révèle une concentration étonnante de leurs sources d’information sur une poignée de sites web majeurs. En 2025, le site communautaire Reddit s’est imposé comme la principale source utilisée par ces IA, devant des piliers de référence tels que Wikipédia ou YouTube. Ce constat soulève des questions cruciales : si les réponses des IA sont majoritairement puisées sur quelques plateformes, qu’en est-il de leur fiabilité, de leurs biais, et de la diversité des perspectives qu’elles reflètent ? Dans un monde où l’IA devient un intermédiaire incontournable pour accéder au savoir, comprendre l’origine de ces réponses est essentiel pour en évaluer la qualité et les limites.

Des sources d’information concentrées sur quelques plateformes

Afin de mieux cerner d’où viennent les connaissances des IA, une étude menée par la société Semrush en collaboration avec Statista a analysé plus de 150 000 références citées dans les réponses de différents chatbots et assistants intelligents au premier trimestre 2025.

Le verdict est sans appel : le paysage des sources se révèle dominé par quelques sites web communautaires et services en ligne grand public.

Plus de 40 % de l’ensemble des citations recensées renvoient ainsi vers Reddit, un forum social où les internautes échangent librement sur tous les sujets imaginables. Wikipédia arrive en deuxième position, représentant environ un quart des sources utilisées, suivie de près par YouTube.

La suite du classement confirme la prédominance de plateformes grand public : on y trouve le moteur de recherche Google lui-même, des sites d’avis et de recommandations comme Yelp (pour les commerces locaux) ou TripAdvisor (pour le tourisme), le réseau social Facebook, le géant du commerce en ligne Amazon (notamment via ses innombrables commentaires clients), ainsi que des services de cartographie comme la base collaborative OpenStreetMap ou son équivalent propriétaire Mapbox.

Ce palmarès met en lumière une tendance forte : les intelligences artificielles s’appuient massivement sur des plateformes alimentées par le contenu des utilisateurs et sur quelques acteurs dominants du web. En revanche, les sources traditionnellement considérées comme très fiables – par exemple la presse d’information générale ou les publications scientifiques de référence – brillent par leur absence dans ce classement. Aucune revue académique majeure ni même un média d’actualité n’y figure, éclipsés par le flot des discussions en ligne et des contributions spontanées. Cette concentration de la connaissance issue de quelques sites pose d’emblée la question d’une éventuelle « monoculture » informationnelle potentiellement dangereuse : si les IA se nourrissent presque exclusivement de ces canaux, elles risquent de refléter principalement les points de vue et les travers qui y dominent, au détriment d’une pluralité de perspectives.

Pourquoi Reddit domine-t-il les réponses des IA ?

Que Reddit arrive en tête des sources des modèles de langage peut surprendre – comment un forum parfois chaotique a-t-il devancé Wikipédia, pourtant réputée pour la fiabilité de son contenu ? Plusieurs facteurs expliquent la suprématie de Reddit dans l’alimentation des IA. D’abord, le volume : Reddit génère chaque jour une quantité colossale de texte en langage naturel. Des millions d’utilisateurs discutent en permanence dans des milliers de « subreddits » thématiques, couvrant des domaines aussi variés que la programmation, la santé, les voyages ou le marketing. Cette profusion dépasse de loin celle de la plupart des autres sites, y compris Wikipédia qui, malgré ses millions d’articles, reste plus limitée en taille.

Ensuite, Reddit a conclu début 2024 un accord de licence notable avec Google (évalué à 60 millions de dollars), permettant à ce dernier d’exploiter l’intégralité des discussions publiques de la plateforme pour entraîner ses intelligences artificielles. Cet accès privilégié a sans doute renforcé la présence de Reddit dans les données d’entraînement de nombreux modèles, notamment ceux utilisés dans des outils de recherche augmentée par l’IA. Par ailleurs, le format même de Reddit joue en sa faveur : les conversations sous forme de questions-réponses entre internautes ressemblent beaucoup au style d’interactions que les IA doivent elles-mêmes produire. En se formant sur d’innombrables fils de discussion, les modèles apprennent des tournures conversationnelles naturelles, des explications vulgarisées et des solutions pratiques à des problèmes concrets – précisément le genre de contenu qu’ils cherchent à restituer aux utilisateurs.

Enfin, la diversité des sujets abordés sur Reddit en fait une mine d’informations éclectiques. Pour presque chaque niche d’intérêt ou problème technique, il existe un subreddit dédié où des connaisseurs partagent conseils et expertises. Aucune encyclopédie, si complète soit-elle, ne peut rivaliser avec cette granularité du savoir d’expérience. Aux yeux des IA, Reddit offre ainsi un corpus vivant, riche en cas concrets et en langage courant, très utile pour formuler des réponses adaptées aux questions du quotidien des utilisateurs.

Il y a toutefois un revers à cette médaille. La prédominance de Reddit interroge quant à la fiabilité de ce qui est appris par les IA. Contrairement à Wikipédia, Reddit ne bénéficie pas d’un processus de vérification systématique des informations. Les contributions y sont publiées sans relecture par des experts ou des modérateurs dédiés (en dehors des communautés spécifiques qui peuvent appliquer certaines règles), et la qualité des propos varie énormément d’un fil à l’autre. Certes, le système de votes (les « upvotes ») met en avant les réponses jugées pertinentes par la communauté, ce qui aide théoriquement à faire émerger le contenu de meilleure qualité. Mais un post plébiscité n’est pas nécessairement exact d’un point de vue factuel : il peut refléter un avis populaire, une expérience subjective convaincante ou même une erreur partagée par beaucoup.

Wikipédia, fiable mais reléguée au second plan

Le cas de Wikipédia contraste fortement avec celui de Reddit. L’encyclopédie en ligne fondée sur la connaissance collective figure depuis longtemps parmi les références incontestées du web en matière de fiabilité de l’information. Son contenu est encadré par des principes éditoriaux rigoureux : citation obligatoire de sources vérifiables, neutralité de point de vue, modération communautaire et corrections continues. Sur un sujet d’actualité ou une notion scientifique, la page Wikipédia correspondante rassemble généralement l’état de l’art et fait l’objet de mises à jour régulières par des bénévoles investis. En théorie, cela en fait une ressource de premier choix pour qui cherche des renseignements solides.

Pourquoi alors les IA citent-elles deux fois moins souvent Wikipédia que Reddit ? Là encore, des raisons structurelles expliquent ce paradoxe. D’une part, Wikipédia représente un volume de texte bien plus restreint que Reddit. Malgré sa considérable ampleur, elle reste une encyclopédie dont le nombre d’articles est fini et la cadence de production modérée. Elle ne peut rivaliser en quantité face au flot ininterrompu de discussions que produisent les forums et réseaux sociaux. D’autre part, le style et le format encyclopédique – langage formel, longues pages descriptives, ton neutre et parfois technique – sont moins directement exploitables pour entraîner des modèles conversationnels. Une IA qui apprend à dialoguer aura plus de facilité à imiter la spontanéité et la concision d’une réponse sur un forum que le style académique d’un article encyclopédique.

Ainsi, malgré ses garanties de fiabilité, Wikipédia se retrouve reléguée au second plan dans l’arsenal des sources privilégiées par les LLMs. Ce n’est pas tant que les modèles « méprisent » Wikipédia, mais plutôt qu’ils sont inondés par des masses de données issues d’autres plateformes plus prolifiques et plus alignées sur leur mode d’expression. Le risque, c’est qu’une réponse d’IA se contente de régurgiter une explication populaire lue sur un forum quelconque, alors même qu’une information plus rigoureuse existe sur Wikipédia mais n’a pas été aussi intensément absorbée par le modèle.

Des sources scientifiques sous-représentées

L’absence de sources scientifiques et académiques dans le haut du classement est un autre signal d’alarme quant à la qualité du savoir mobilisé par les IA. Ni les grandes revues savantes (Nature, Science, The Lancet, etc.), ni les bases de données universitaires, ni même les médias d’information reconnus n’apparaissent parmi les dix sources les plus exploitées. Plusieurs facteurs expliquent cette mise à l’écart. D’abord, l’accessibilité : la majorité des publications scientifiques sont protégées par des paywalls ou des licences restreintes. Leur contenu n’est pas librement indexé sur le web, ce qui rend son utilisation compliquée pour entraîner des IA grand public. À l’inverse, Reddit, Wikipédia ou YouTube sont en libre accès et leurs données peuvent être aisément aspirées ou référencées.

Ensuite, le format des articles scientifiques et des rapports d’experts est peu compatible avec les usages des LLMs actuels. Il s’agit souvent de textes longs, truffés de jargon technique et ciblant un public spécialisé. Résumer ou vulgariser ces documents complexes requiert un effort d’analyse que les modèles n’accomplissent pas spontanément lorsqu’ils apprennent sur le tas à partir de corpus bruts. Ils auront tendance à ignorer ou mal interpréter ce type de contenu s’il est dilué dans la masse, d’autant plus que son volume global est infime comparé aux milliards de mots disponibles sur les forums grand public.

Il y a aussi la question du contexte d’utilisation des IA : on sollicite rarement un chatbot grand public pour lire une publication académique en détail. Les questions posées aux IA portent bien plus fréquemment sur des conseils pratiques ou des explications vulgarisées que sur des analyses de laboratoire pointues. De ce fait, même si un modèle a vu passer des résumés de recherches, il est peu entraîné à en fournir l’essence car ce n’est pas ce qu’on lui demande le plus souvent. Le résultat, c’est que pour un sujet scientifique ou médical, l’IA risque de s’appuyer sur ce qu’elle a appris de second main via des articles Wikipédia, des blogs ou des discussions sur des forums de vulgarisation, plutôt que d’aller puiser directement à la source primaire de la connaissance experte. Cette perte d’exactitude et de profondeur est préoccupante dès lors qu’on attend de l’IA des réponses de haute qualité sur des enjeux complexes.

Biais et risques inhérents à la concentration des sources

Si les IA ne font que refléter le contenu majoritaire du web, sans distinction de fiabilité, plusieurs biais et distorsions peuvent en découler. Le premier est un biais de popularité : les informations ou opinions largement répandues en ligne se trouvent surreprésentées dans les réponses générées, au détriment de connaissances plus confidentielles ou moins accessibles. Autrement dit, ce n’est pas la véracité d’une assertion qui garantit qu’une IA la reprenne, mais sa fréquence d’apparition. Un concept erroné répété sur de nombreux forums aura plus de chances d’être intégré et restitué qu’un fait exact mentionné seulement dans une obscure publication spécialisée. Ce biais de fréquence est inhérent au fonctionnement statistique des LLMs, qui produisent le mot suivant en fonction de la probabilité calculée sur la base de leur corpus d’entraînement.

Un second biais, corrélé, est celui de la nature même des contenus dominants : la préférence donnée aux savoirs pratiques et aux retours d’expérience informels, aux dépens des connaissances académiques ou des données étayées par la recherche. Par exemple, face à une question sur un remède contre un mal de dos, un chatbot puisera plus volontiers dans les nombreux témoignages ou astuces partagés sur un forum santé que dans une méta-analyse médicale pointue parue dans une revue de recherche, qu’il aura peu de chances d’avoir beaucoup « lus ». L’internaute obtiendra alors une réponse possiblement biaisée par des croyances populaires ou des cas particuliers, plutôt qu’un avis médical fondé sur des études solides. Ce basculement vers le conseil empirique présente un risque réel de désinformation dans des domaines sensibles comme la santé, la finance ou l’environnement, où les données scientifiques fiables devraient primer sur l’opinion commune.

La surreprésentation de certaines plateformes peut aussi amplifier un biais culturel et géographique. Les sites en anglais, et plus généralement ceux issus de la sphère occidentale, dominent le paysage en ligne et donc l’entraînement des IA. Reddit, Wikipédia, YouTube ou Facebook sont des produits de l’internet américain et leurs contenus reflètent majoritairement des perspectives nord-américaines ou européennes anglophones. En conséquence, un modèle de langage risque de fournir des réponses centrées sur une vision occidentale du monde, négligeant des points de vue issus d’autres cultures ou régions moins présentes sur ces grandes plateformes. Des stéréotypes ou partis pris propres aux communautés en ligne les plus actives (jeunes adultes occidentaux, par exemple) peuvent transparaître involontairement dans les réponses de l’IA. Ce manque de diversité des sources pose une question d’équité et de représentativité : les intelligences artificielles ne devraient-elles pas intégrer de manière plus équilibrée des connaissances provenant d’aires culturelles et linguistiques variées, afin de servir un public mondial de manière pertinente ?

En outre, s’appuyer sur quelques sites majeurs rend les IA vulnérables aux dérives ou aux manipulations touchant ces mêmes sites. Si une campagne de désinformation coordonnée inonde Reddit ou Facebook sur un sujet donné, l’IA entraînée sur ces données pourrait en absorber les mensonges et les présenter plus tard comme des réponses légitimes. De même, si les algorithmes de ces plateformes favorisent certains contenus biaisés ou extrêmes (par effet de bulle de filtres ou de viralité), les modèles de langage risquent d’hériter de ces tendances. La centralisation des sources accroît ainsi le risque d’une contamination à grande échelle par des contenus problématiques, là où une diversité de sources aurait pu atténuer l’impact d’un site isolément biaisé.

Enfin, cette concentration pourrait freiner l’évolution positive de l’écosystème de l’information. En monopolisant l’attention des IA sur un cercle restreint de sites, on réduit potentiellement l’incitation à produire du contenu de qualité en dehors de ces plateformes. Les créateurs de contenu ou experts qui publient sur des blogs spécialisés, des sites locaux ou des revues moins connues voient leur visibilité compromise face à la puissance de Reddit ou YouTube. À l’ère où de plus en plus d’utilisateurs se tournent vers les réponses synthétiques des chatbots plutôt que vers les résultats de recherche classiques, il y a un risque que l’écosystème du web s’appauvrisse : moins de trafic vers les sites originaux, une concentration de l’audience sur ce que l’IA restitue, et in fine une possible uniformisation du savoir disponible.

On voit d’ailleurs les premiers signes de cette évolution sur le plan du marketing et de la production de contenu. Pour rester visibles via les réponses d’IA, entreprises et médias investissent de plus en plus les canaux dominants du web. Publier des tutoriels sur YouTube, intervenir dans des discussions sur Reddit ou enrichir des pages Wikipédia est désormais perçu comme un moyen d’« apparaître » dans le flux d’information consulté par les intelligences artificielles. Si cette adaptation est compréhensible, elle risque d’accentuer encore la centralisation du savoir en ligne autour de quelques plateformes incontournables.

Quelles solutions pour améliorer la qualité des réponses de l’IA ?

Conscients de ces limites, chercheurs et acteurs du domaine de l’intelligence artificielle explorent plusieurs pistes pour diversifier et fiabiliser les sources d’information des modèles de langage. L’une d’elles consiste à développer des modèles ou des outils spécialisés capables d’exploiter la littérature scientifique ouverte. Par exemple, des moteurs comme Semantic Scholar ou des assistants de recherche comme Elicit travaillent à rendre accessible le contenu de publications universitaires en les résumant ou en en extrayant des réponses pertinentes. Intégrer de tels systèmes à l’entraînement ou au fonctionnement des IA généralistes pourrait rééquilibrer la balance en faveur de connaissances validées par la communauté scientifique.

Une autre approche investiguée est la pondération des sources en fonction de leur fiabilité présumée. Plutôt que de « noyer » le modèle sous un flux de données brutes où une page Reddit a autant de poids qu’un article du Monde ou qu’une étude du CNRS, on pourrait imaginer des entraînements où les textes sont préalablement évalués et étiquetés selon leur niveau de confiance. Ainsi, une affirmation trouvée dans une source réputée pourrait être renforcée ou annotée différemment qu’une rumeur issue d’un forum anonyme. Ce genre de hiérarchisation est complexe à mettre en œuvre sans introduire d’autres biais (qui décide qu’une source est fiable, sur quels critères ?), mais il pourrait constituer un garde-fou utile pour éviter la propagation de contenu trompeur.

En parallèle, les concepteurs de chatbots cherchent à intégrer des mécanismes de vérification factuelle dans les réponses générées. Des modules de « fact-checking » automatiques sont à l’étude pour corriger en temps réel une hallucination ou une information douteuse fournie par le modèle. Par exemple, si l’IA affirme qu’un événement X s’est produit en 2018, un système peut vérifier dans une base de données de presse si c’est exact et ajuster la réponse en conséquence. Cela nécessite là encore d’avoir accès à des sources de référence fiables et à jour, ce qui ramène à l’importance de diversifier les données d’entraînement et d’inférence.

Du côté des utilisateurs et de la société, une prise de conscience s’amorce sur la nécessité de transparence quant aux sources utilisées par les IA. Certains moteurs de recherche dopés à l’IA, comme le mode conversationnel de Bing, affichent en temps réel les références web sur lesquelles ils s’appuient pour formuler une réponse. Ce type d’initiative permet à l’usager de juger de la crédibilité de l’information donnée – par exemple, distinguer si un conseil médical vient d’un forum ou d’un site institutionnel de santé. Généraliser la citation des sources dans les réponses d’IA, sans alourdir l’expérience utilisateur, pourrait encourager une consommation plus critique des informations fournies par les modèles. Par ailleurs, les pouvoirs publics commencent à examiner ces enjeux. En Europe notamment, le projet de règlement AI Act prévoit d’obliger les concepteurs de systèmes d’IA à documenter les données d’entraînement utilisées – une mesure qui pourrait améliorer la traçabilité et, indirectement, la diversité et la qualité des sources ingérées par les modèles.

Enfin, il ne faut pas négliger que les IA reflètent aussi les usages que nous en faisons. La prédominance de sites comme Reddit ou Yelp dans leurs réponses tient pour partie au fait que nous sollicitons beaucoup les IA sur des sujets du quotidien ou de loisirs, justement ceux où l’expérience de la foule prime sur l’expertise formelle. Demain, si les utilisateurs poussent les IA vers des requêtes plus pointues – par exemple en interrogeant sur des données scientifiques précises, en demandant des sources ou des comparaisons d’études – les modèles et leurs concepteurs devront s’adapter à ces attentes. En d’autres termes, l’amélioration de la qualité des réponses passe aussi par l’éducation des utilisateurs à questionner l’IA de manière exigeante, et par un dialogue continu entre la technologie et son public pour orienter son évolution.

Conclusion

Le fait que les réponses des intelligences artificielles actuelles proviennent en grande partie d’un nombre restreint de sites web communautaires et commerciaux constitue un enjeu majeur pour l’avenir de la connaissance numérique. D’un côté, cette réalité reflète nos usages : nous avons créé des plateformes participatives foisonnantes qui sont devenues des référentiels pratiques pour résoudre les problèmes du quotidien. De l’autre, elle met en évidence les fragilités d’une IA qui, en l’état, agrège plus qu’elle n’analyse, et peut amplifier les biais du web au lieu de fournir un savoir filtré et fiable.

Assurer la qualité, la fiabilité et la diversité des informations fournies par les IA nécessitera des efforts conjugués. Les concepteurs de modèles doivent innover pour intégrer des sources plus variées et évaluer la véracité du contenu qu’ils génèrent. Les plateformes de contenu doivent, quant à elles, prendre conscience de leur responsabilité en tant que pourvoyeuses de données d’entraînement – et peut-être renforcer leurs propres mesures de modération et de vérification pour élever le niveau global. Enfin, les utilisateurs et décideurs ont un rôle à jouer en réclamant de la transparence et en soutenant les initiatives qui visent à élargir l’assise informationnelle de nos intelligences artificielles.

À l’aube d’une ère où les chatbots et autres conseillers virtuels seront omniprésents dans la recherche d’information, il est impératif de veiller à ce qu’ils ne deviennent pas simplement l’écho des tendances dominantes du web. Leur véritable potentiel réside dans leur capacité à synthétiser l’ensemble des connaissances humaines de manière équilibrée et éclairée. Pour y parvenir, ils devront apprendre à dépasser la facilité des sources abondantes mais inégales, et puiser davantage dans les réservoirs de savoirs de haute qualité – fussent-ils plus difficiles d’accès. L’avenir de l’IA, en tant que guide fiable dans la jungle informationnelle, dépendra de cette évolution.

En fin de compte, donner aux IA les moyens de répondre de manière réellement fiable et diversifiée équivaut à leur permettre de dépasser le simple reflet du web existant pour devenir de véritables outils de connaissance à valeur ajoutée. C’est un défi collectif majeur qu’il nous faudra relever pour que l’ère de l’information automatisée tienne toutes ses promesses.